L’intelligence artificielle pour décoder les pensées

Malgré les progrès récents en imagerie cérébrale, la représentation du monde visuel par le cerveau reste encore largement méconnue. En utilisant une nouvelle technique d’intelligence artificielle – le « deep learning » – pour décoder l’activité cérébrale enregistrée en imagerie fonctionnelle, les chercheurs ont pu reconstruire les images vues – ou imaginées – par des sujets. Cette méthode, parue dans la revue Nature Communications Biology, ouvre la porte à de nouvelles explorations du cerveau.

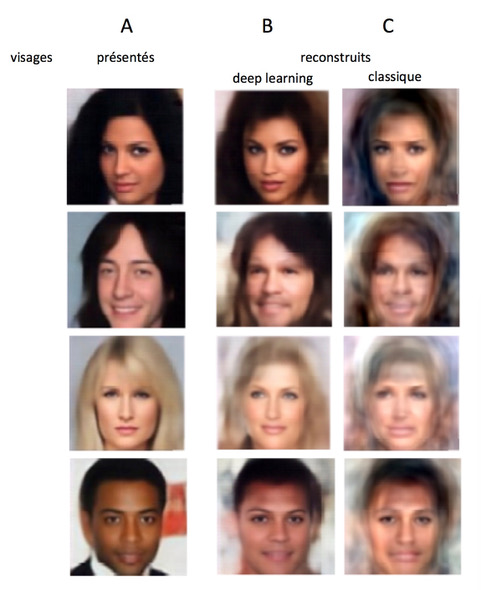

Décoder les informations sensorielles issues de l'activité cérébrale constitue un défi technologique de taille, et une question fondamentale pour les Neurosciences du XXIème siècle. Alors qu’au cours de ces 15 dernières années, les modèles classiques ont pu décoder de manière fiable des objets appartenant à différentes catégories (visages vs maison par exemple), ils ne permettent pourtant pas de différentier des objets d’une même catégorie (visage souriant vs visage triste par exemple). En utilisant une technique d’intelligence artificielle récemment développée, le « deep learning », les chercheurs ont entrainé de façon non supervisée un réseau de neurones artificiels à représenter plus de 200 000 visages tirés d’une base de données de célébrités. Chaque visage est projeté dans un espace « latent » en 1024 dimensions (certaines correspondant à des graduations de sourires, genres, sourcils, couleurs de peau etc.) qui peuvent être combinées de façon linéaire pour générer de nouveaux visages réalistes. Ce type de réseau neuronal génératif (ou GAN) est à la pointe des progrès récents en « deep learning ». Ce système a ensuite permis aux chercheurs d’apprendre la correspondance entre l’activité cérébrale enregistrée en IRMf à la vue de plus de 8000 visages et la représentation dans l’espace latent de ces mêmes visages. Durant la phase de test, de nouveaux visages étaient présentés, et l’activité cérébrale correspondante était utilisée par le réseau pour reconstruire l’image via cet espace latent. La fiabilité du système peut être estimée par la comparaison des visages en entrée et en sortie ; les visages étaient reconnaissables dans plus de 95% des cas, les modèles précédents ne permettant pas de dépasser une fiabilité de plus de 85%.

Outre la très grande résolution obtenue par ces réseaux issus du « deep learning », ces résultats ont permis de préciser les zones cérébrales impliquées dans le traitement des visages et notamment le traitement du genre (zones occipitale et temporale principalement). Enfin, la fiabilité du réseau a également été testée en demandant aux sujets non pas de regarder un visage mais de se l’imaginer : l’activité enregistrée dans la zone temporale du cortex permettait au réseau neuronal de « deviner » le visage choisi avec une précision de plus de 80%.

En lisant et en comprenant les informations sensorielles présentes dans le cerveau cette nouvelle méthode de décodage va permettre de répondre à un grand nombre de questions fondamentales concernant le traitement des visages, et plus généralement le fonctionnement cérébral ; les auteurs font l’hypothèse que l’espace latent des modèles de « deep learning » en IA pourrait être comparable aux représentations du cerveau humain.

© Rufin VanRullen & Leila Reddy

Pour en savoir plus :

Reconstructing faces from fMRI patterns using deep generative neural networks

Rufin VanRullen & Leila Reddy

Communications Biology, may 21 (2019). DOI : 10.1038/s42003-019-0438-y